El despegue del Software 2.0 🚀

Noticias recientes de Inteligencia Artificial que importan a los negocios

Cuando Andrej Karpathy acuñó el término Software 2.0 en el año 2017, todavía no éramos conscientes de la repercusión de este cambio de paradigma en el software que hoy sí vemos con claridad. Y es que estamos asistiendo a la democratización del Software 2.0 a una velocidad de vértigo; cada día se publican nuevos modelos de Inteligencia Artificial que hasta ahora sólo estaban en manos de las grandes tecnológicas. Esto abre la puerta a la creación de nuevas aplicaciones hasta ahora impensables, nacidas del ingenio de una comunidad open source cada vez más versada en este nuevo paradigma. En este Explicable vamos a ver algunos ejemplos de aplicaciones basadas en grandes modelos de lenguaje (LLM, Large Language Models), aplicados como “piezas de Lego” para resolver problemas muy concretos y de gran valor comercial. También, repasaremos los esfuerzos para poder comercializar estos modelos al público general y que sirvan de asistentes virtuales vitaminados. Y por último, analizaremos cuál es el estado actual de la conducción autónoma, una tecnología en la que se depositaron grandes esperanzas y que todavía no ha podido demostrar todo su potencial.

¿Y para qué sirve un LLM?

Muchos se hacían esta pregunta cuando GPT-3 asombró al mundo con su capacidad de completar cualquier texto de manera coherente. Podía clasificar el sentimiento de tweets sin haber sido entrenado específicamente para ello, pero ya teníamos modelos más pequeños que también lo podían hacer. Podía escribir un artículo divulgativo sobre cualquier tema, con la estructura adecuada, pero con un contenido de escaso valor y en ocasiones redundante. Alentados por la revolución en la generación de imágenes guiadas por texto de Dall-E y StableDiffusion, los LLMs vuelven a invadir el campo del Software 2.0, constatando que hemos entrado en una nueva era de la historia de la computación. A continuación, enumeramos algunas de esas aplicaciones surgidas recientemente, una lista que habla por sí misma del contexto tan abrumador en el que nos hallamos.

Deepmind lanza un proyecto llamado Dramatron, que a partir de un LLM adaptado a guiones, ayuda a los guionistas a producir ideas de historias, personajes y tramas. Lo han probado con guionistas reales y la mayoría reconoce que un sistema así les permite ser más productivos (lo cual tiene un valor doble, considerando la resistencia al cambio que suele acompañar a este tipo de experimentos).

Code as Policies (CaP) es el proyecto de Google para generar una serie de comandos que un robot es capaz de interpretar, con el fin de realizar una tarea. Lo novedoso es que esos comandos se generan a partir de un LLM al que se le ha introducido la tarea en forma de texto, utilizando lenguaje natural. La gran ventaja de esta aproximación es que el robot no se ciñe a un conjunto de tareas preestablecidas y es capaz de realizar cualquier tarea que se pueda describir con palabras.

OpenAI y Microsoft nos han enseñado una demo muy impactante de su LLM especializado en lenguajes de programación, llamado Codex. En esta ocasión, hemos visto a Codex produciendo código para resolver un problema descrito en lenguaje natural. Lo más sorprendente es que cuando el programa generado no funciona, el modelo vuelve a producir nuevo código las veces que sea necesario hasta llegar a la solución correcta.

Meta ha publicado ESM Metagenomics Atlas, un LLM especializado en la descripción de proteínas, que conforman el lenguaje de la vida. Este LLM está especializado en predecir la estructura tridimensional de las proteínas metagenómicas, que son las menos conocidas por no formar parte de las proteínas que encontramos en animales y plantas. Dado que el número de estas proteínas es del orden de cientos de millones, un LLM que pueda capturar este conocimiento es fundamental para obtener predicciones que ayuden a entender mejor los procesos biológicos, de vital importancia para la industria farmacéutica.

Con Inter Alia, un LLM nos permite hacer una búsqueda de ropa a partir de la descripción de lo que queremos.

Creada en la plataforma Dust, un asistente basado en un LLM nos ayuda en el proceso de búsqueda por Internet. Compila la información de varios resultados de búsqueda y nos muestra de forma resumida lo que estamos buscando exactamente, evitando el tedioso proceso de navegar por multitud de páginas web con exceso de información irrelevante.

Mubert ha creado un modelo para generar música guiada por texto, un proceso todavía rudimentario, pero con mucho margen de mejora que seguro veremos en los próximos años.

Un ávido lector llamado Dwarkesh Patel, ha creado mediante GPT-3 una aplicación para hacer una búsqueda semántica en los libros que lee. Esto permite buscar un pasaje explicando en lenguaje natural lo que allí se cuenta, sin que sea preciso recordar las palabras de búsqueda exactas que allí aparecen.

Un ingeniero de software llamado Linus, ha creado también mediante GPT-3 una aplicación para responder dudas que surgen mientras está programando. Afirma que es más rápido y más eficaz que consultar el popular sitio web Stack Overflow, un foro de programadores que se ayudan con este tipo de cuestiones.

Estos son sólo algunos ejemplos de aplicaciones basadas en un LLM, siendo GPT-3 el más popular debido a que fue el primero y a que tiene un modelo de pago por uso, apto para fines comerciales. Pero no es el único, y ya con dos años de existencia tampoco es el mejor. Este mismo año se han liberado modelos como Bloom y OPT-175B, a la par con GPT-3 en tamaño, aunque su repercusión en la comunidad open source ha sido bastante menor. Además, Google acaba de liberar Flan-T5, un modelo más pequeño que GPT-3 que le supera en prestaciones. Estos movimientos confirman que, desde la irrupción de Stability.ai, otras empresas se animan a compartir sus modelos ya entrenados. Sin embargo, la gran diferencia con respecto a Stability.ai son sus licencias más restrictivas, que impiden cualquier uso comercial de estos modelos.

Modelos de lenguaje reeducados

Uno de los usos más evidentes de los LLM es la posibilidad de conversar con ellos para obtener cualquier tipo de información, o realizar cualquier gestión por nosotros. Es lo que se conoce como chatbots de dominio abierto, que a diferencia de los sencillos chatbots con los que estamos acostumbrados a interactuar, no se ciñen a un conjunto de tareas predefinidas de las que no te puedes salir. Sin embargo, cuando se utilizan estos grandes modelos de lenguaje para mantener una conversación, es fácil que un usuario los pueda conducir hacia un uso del idioma que no cumple con los mínimos criterios de corrección. El primer caso ocurrió con Tay, un chatbot de Microsoft lanzado en 2016, que comenzó a escribir tweets racistas y tuvo que apagarse tras 48 horas de funcionamiento. Más recientemente tenemos la publicación de BlenderBot 3, un chatbot de dominio abierto basado en un modelo del tamaño de GPT-3 y que también fue noticia por generar opiniones controvertidas.

Estos LLMs han visto texto muy diverso, incluyendo conversaciones no apropiadas, que de forma involuntaria y muy reducida se cuelan en el conjunto de entrenamiento.

De este modo, un usuario avispado encuentra fácilmente la forma de llevar la conversación por esos derroteros, logrando producir respuestas que son inadmisibles en el contexto de nuestra sociedad.

Para solucionar este problema, ha aparecido una técnica llamada RLHF (Reinforcement Learning from Human Feedback). Con esta técnica, las respuestas del modelo son evaluadas por humanos, lo cual se traduce en una recompensa para animar al modelo a que produzca más de esas respuestas, o por el contrario, un castigo para evitar que se vuelvan a repetir. De esta manera estamos “enseñando modales” a un LLM.

Sparrow es el LLM de Deepmind entrenado con esta técnica, que obtiene conversaciones más acordes con nuestros principios fundamentales. En el estudio que han publicado, indican que todavía no han sido capaces de eliminar ciertos sesgos, lo cual todavía impide utilizar este modelo como chatbot de dominio abierto para usuarios finales. En el mundo open source de Stability.ai también tenemos una iniciativa llamada CarperAI que está entrenando un modelo de lenguaje conversacional con la misma técnica RLHF, y que se podría usar para fines comerciales si mantienen su filosofía como hasta ahora.

Los chatbots (o asistentes virtuales) de dominio abierto son el santo grial de las grandes tecnológicas para que puedan seguir ofreciéndonos servicios a escala global una vez cambie la forma de interactuar con los ordenadores. Por eso, no es de extrañar que empresas como Google inviertan todos los años grandes sumas de dinero en investigación básica de LLMs.

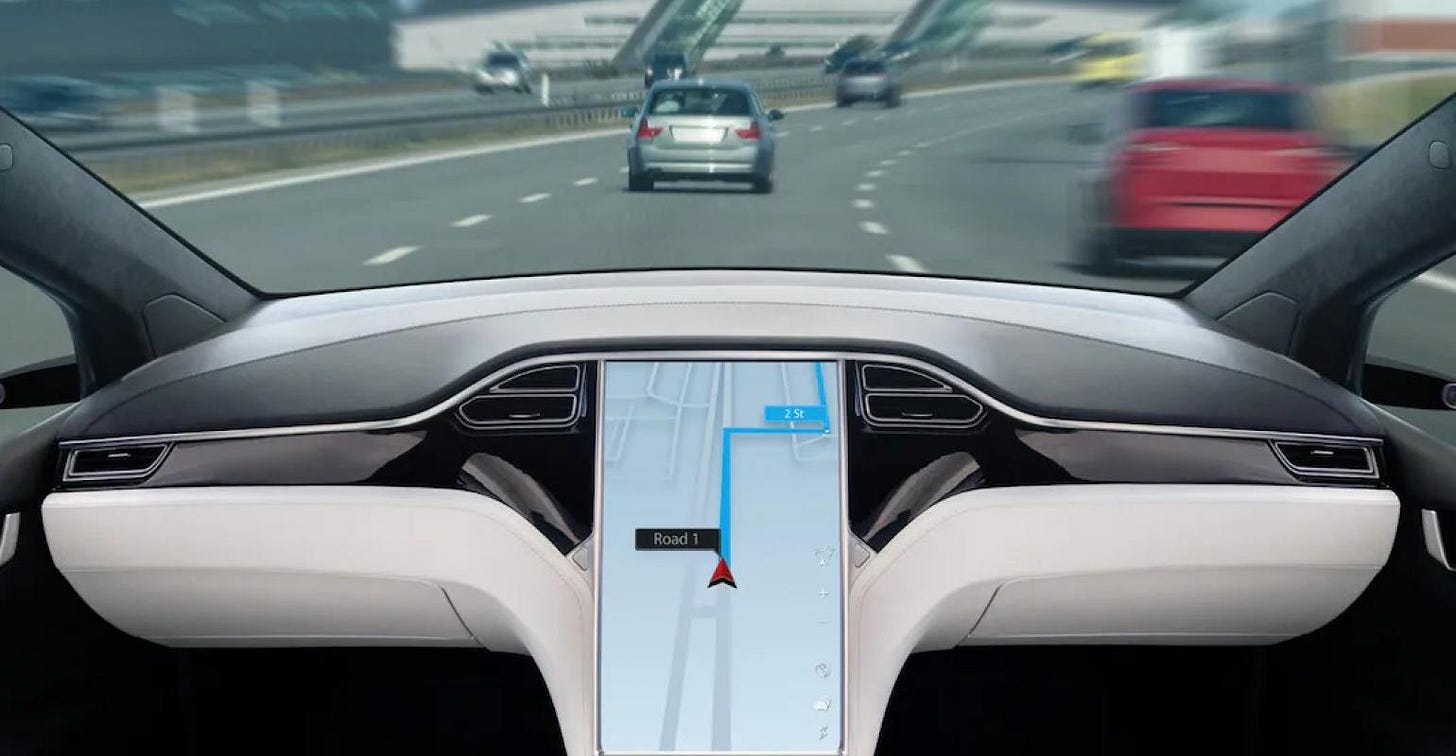

Conducción autónoma: ¿Quo Vadis?

Nos remontamos al 30 de septiembre de 2012. Ocurre el momento Imagenet, que supone un cambio de paradigma en la computación. El deep learning por fin funciona, y permite a las máquinas adquirir habilidades de percepción visual que hasta entonces formaban parte de la ciencia ficción. En ese momento, se empieza a ver la conducción autónoma como un producto viable y aparecen multitud de empresas muy bien financiadas que tratan de ser los primeros. Los mayores expertos en la materia auguraron que la conducción totalmente autónoma llegaría como muy tarde en 2020. Sin embargo, 10 años después nuestros jóvenes siguen examinándose del carnet de conducir. ¿Qué ha pasado con esta tecnología que prometía transformar la economía y mejorar nuestra sociedad?

La realidad es que el nivel de percepción visual requerido para la conducción ha resultado ser mucho más alto de lo que se pensaba. Las condiciones meteorológicas, el estado de las señales de tráfico, unos patitos cruzando la carretera o un peatón disfrazado de Spiderman en Carnaval pueden confundir al sistema de percepción de un coche autónomo. En los últimos años se han hecho muchos avances a este respecto que, sin duda, van a subsanar este problema. Pero, además de la percepción, la conducción autónoma también requiere resolver la tarea de planificación, que consiste en decidir qué acciones tomar para mover el coche de un punto a otro. Esto implica predecir lo que van a hacer los conductores, peatones, y demás humanos que intervienen en las vías públicas para poder tomar las decisiones correctas. Todo ello siguiendo las normas establecidas y otras convenciones de sentido común no escritas que forman parte de nuestro conocimiento del mundo.

Y aquí es donde los casos que un sistema basado en IA debe aprender se disparan. Es lo que se conoce como el long tail de situaciones imprevistas, que los humanos sabemos resolver gracias a nuestra capacidad de abstracción y razonamiento.

La consecuencia es que el mercado de la conducción autónoma está pasando por su peor momento, con caídas del 80% de media en aquellas empresas del sector que salieron a bolsa. Esto no implica que se haya parado todo el I+D relacionado con la conducción autónoma. Todavía tenemos muchas iniciativas privadas que siguen levantando fuertes rondas de inversión, tanto en EE.UU. como en China. Pero el sentimiento general es que hace falta más tiempo: Ford ha cerrado su división de coches autónomos también co-financiada con Volkswagen; y el célebre George Hotz ha abandonado la empresa que fundó (comma.ai) tras años sin encontrar la rentabilidad. A nivel de despliegue real tenemos el ejemplo de Cruise, la división de conducción autónoma de General Motors, que opera taxis sin conductor en una zona acotada de San Francisco. Desde entonces, se han multiplicado las quejas de conductores que afirman que estos vehículos a menudo se quedan parados en medio de la calle provocando grandes atascos. Al menos parece que ninguno de los incidentes reportados están relacionados con problemas de seguridad para las personas.

Y quizá sea este otro de los motivos del lento avance de la conducción autónoma: el elevado coste de los errores cometidos por un vehículo que circula a gran velocidad rodeado de personas. Las primeras aplicaciones de inteligencia artificial que están transformando el mundo son aquellas con tolerancia a fallos. Así que es muy probable que la conducción autónoma llegue antes a la agricultura, donde los fallos no tienen consecuencias fatales, que a la carretera.

Gracias por leer Explicable. Si te ha gustado esta edición, no te olvides de dar al ♡ y de compartirla por redes sociales o por email con otras personas a las que creas que les pueda gustar. 💥Pero atención…💥 Si no recibieses Explicable directamente en tu correo, revisa bien tu correo no deseado. A veces ocurre que nuestros mensajes se van directamente a ese agujero negro denominado “spam”. Para evitar que esto ocurra, marca nuestra dirección de correo como “no es spam”. Si eres usuario de Gmail, revisa también la carpeta de “promociones”, porque puede que también nos hayamos escondido allí y mueve el mensaje al inbox principal. GRACIAS.