El súper adelantamiento de Tesla

Noticias recientes de Inteligencia Artificial que importan a los negocios

Analizamos cuatro logros relacionados con la Inteligencia Artificial de las últimas semanas que nos abren una rendija al futuro de este campo. Tesla avanza en su fuerte apuesta por construir un robot humanoide que cambie el mundo para siempre; OpenAI se hace realmente “open” publicando un modelo de transcripción automática para múltiples idiomas con una calidad que supera a los que se comercializan en la actualidad; Meta lanza el primer generador de vídeos guiado por texto, y acto seguido, Google saca músculo mostrando el suyo aparentemente superior; y Deepmind aprovecha sus potentes modelos de juegos (Ajedrez, Go, Atari) para encontrar un algoritmo de multiplicación de matrices con un coste menor de computación. No hay días suficientes en la semana para estar al tanto de todos los avances que suceden en la inteligencia artificial.

Tesla: AI Day 2022

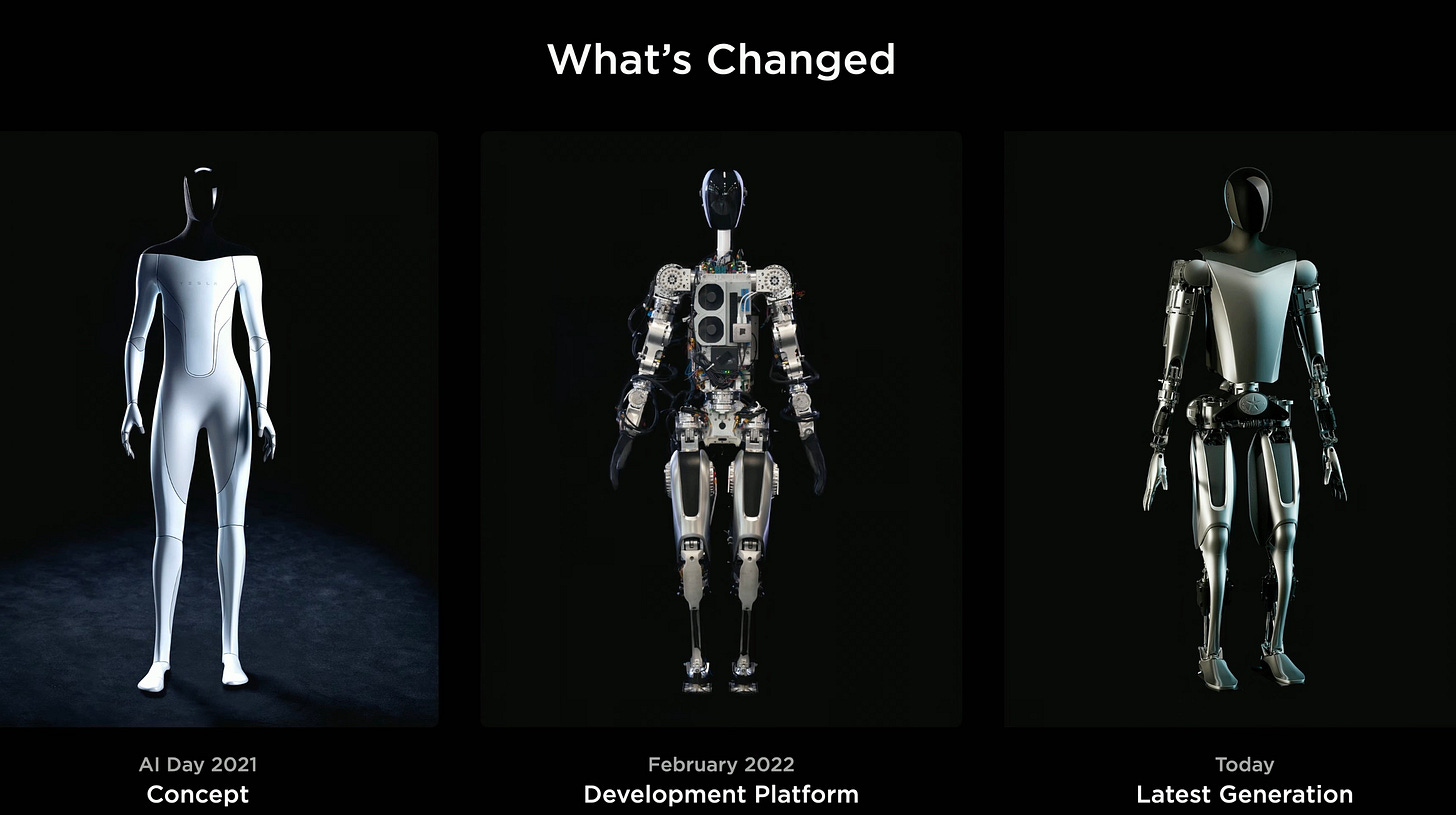

Desde hace un año Tesla celebra al final del verano su AI Day, que es un evento que tiene como finalidad enseñar su hoja de ruta para atraer a los mejores ingenieros del mundo. Por eso, no podemos comparar este evento con los de Apple o Google, orientados al consumidor de sus productos y cuyo fin es presentarle sus últimas novedades. El primer AI Day de hace un año sirvió para que Tesla se posicionara como algo más que un fabricante de coches, presentándose como una empresa de IA cuyo objetivo final es la construcción de un robot capaz de adaptarse a cualquier tarea que pueda hacer un humano. Por aquel entonces, esto no era más que un propósito, así que utilizaron a una persona disfrazada de robot bailando en el escenario, siendo objeto de una intensa crítica y burla por parte de expertos en robótica.

Lejos de achantarse, en el AI Day de este año, Tesla nos ha presentado a Optimus, el primer prototipo de este robot que ha salido al escenario por su propio pie y ha sido capaz de saludar a los asistentes. Algo sencillo para un humano, pero extremadamente complejo para una máquina, como nos recuerda la paradoja de Moravec.

Y a pesar de que queda mucho camino por recorrer, ya hemos pasado de la burla a una gran expectación.

El salto de ingeniería que ha hecho Tesla en tan sólo un año es espectacular, demostrando que van totalmente en serio con su propósito. Según Elon Musk, Optimus estará listo para ser comercializado dentro de 3 a 5 años por un precio de 20 mil dólares, resultando más asequible que un coche. Teniendo en cuenta que Elon Musk siempre ha sido optimista con sus propias estimaciones, debemos tomar estos datos con pinzas.

Al margen de lo cerca o lejos que estemos, lo más interesante de este proyecto es que alguien se haya atrevido a dar el primer paso. El impacto que un robot como Optimus podría tener en la sociedad es descomunal, algo que podría cambiar conceptos como el del trabajo para siempre. Por eso, Optimus está diseñado con la forma de un humano, para estar adaptado desde la primera versión al mundo que hemos construido para nosotros, teniendo en cuenta la forma y posibilidades de nuestro cuerpo. Aunque por reducción de costes el cuerpo de Optimus es una simplificación del cuerpo humano, Tesla espera que no le impida realizar la mayoría de tareas que hace un humano. El consumo estimado de Optimus es de 100 vatios en reposo y 500 en movimiento, y viene equipado con una batería que, haciendo cálculos, le permitiría 4.5 horas en movimiento y 23 horas en reposo. Optimus cuenta con un total de 28 actuadores situados en las articulaciones, algunos de los cuales son capaces de levantar un piano de media tonelada. Cada mano dispone de 6 de estos actuadores con 11 grados de libertad, algo que mejora sustancialmente los brazos robóticos comerciales que poseen manos basadas en pinzas. En definitiva, el hardware de Optimus parece estar bastante avanzado y listo para operaciones.

Sin embargo, lo que parece que está menos desarrollado aún son las funciones cognitivas, es decir, la inteligencia artificial que hace que este proyecto tenga sentido. En la presentación apuntaron que el cerebro de Optimus tendrá la misma arquitectura que el sistema de conducción autónoma de sus coches, pero no han explicado exactamente qué técnicas van a emplear para encontrar el santo grial de la robótica. El reto técnico que tiene Tesla entre manos es de proporciones gigantescas. Esto ha generado mucho escepticismo en la comunidad de expertos en robótica. Lo que es innegable es que el progreso que han logrado en apenas un año invita a soñar, colocando Tesla al nivel de empresas como Boston Robotics que lleva 30 años fabricando robots. La obstinación de Elon Musk por atacar los grandes problemas de la humanidad mediante ingeniería no tiene límites, y Optimus se añade a esta lista.

Más info:

Meta/Google: hazme un vídeo

El vídeo es la fuente de información más abundante que tenemos hoy en día y que más consumimos a través de Internet. La mayoría de aplicaciones de deep learning para vídeo se basan en un modelo entrenado para imágenes que se aplica a cada fotograma del vídeo de manera independiente, por ejemplo, para seguir la trayectoria de una persona. Pero, en el último año estamos empezando a ver modelos que se entrenan con el vídeo completo, procesando conjuntamente los fotogramas y la evolución o el movimiento de los mismos. Esto permite entender lo que está pasando en un vídeo, por ejemplo. para detectar el inicio de una pelea o una situación de riesgo en una escena. Los modelos de IA aplicados a vídeo precisan de una capacidad de cómputo mucho mayor que la de otras fuentes de datos, debido a que tienen que procesar mucha más información. Esto, unido a la escasez de conjuntos de datos de vídeo etiquetado, ha hecho que la evolución de estos modelos sea más lenta.

Meta acaba de dar un paso importante en este sentido con un modelo llamado Make-A-Video, que genera vídeos a partir de una descripción. Lo más llamativo es cómo han suplido la falta de vídeos etiquetados en el conjunto de entrenamiento. Por un lado, han utilizado el mismo conjunto de datos de StableDiffusion de imágenes con su descripción para guiar la generación mediante texto. Y, por otro lado, han utilizado técnicas de aprendizaje auto-supervisado con 20 millones de vídeos sin ninguna descripción asociada, únicamente con el fin de aprender a generar vídeos con consistencia temporal.

Los resultados todavía no tienen la calidad suficiente para poder utilizarse a nivel profesional, pero ya sabemos que, una vez se confirma la viabilidad de un modelo de IA, mejorar la calidad es sólo cuestión de tiempo.

La prueba es que tan sólo 1 semana más tarde, Google ha publicado su modelo, llamado Imagen Video, basado en los mismos principios, pero con unos resultados que parecen superiores. Lamentablemente, estos modelos no están disponibles para que podamos hacer pruebas, aunque no tardaremos en ver a la comunidad de Stability.ai manos a la obra.

Más info: https://ai.facebook.com/blog/generative-ai-text-to-video/

Deepmind: la ciencia es un juego

La empresa Deepmind saltó a la fama en 2013 cuando mostraron un modelo de inteligencia artificial capaz de jugar mejor que los humanos a los juegos de la famosa consola de los años 80 Atari 2600. Esto provocó la inmediata adquisición de Google por 500 millones de dólares en plena fiebre por no quedarse atrás en Inteligencia Artificial. Posteriormente, vendrían otros logros muy sonados como AlphaGo, que fue capaz de vencer al campeón del mundo de Go, o AlphaZero, que aprendió juegos como el ajedrez desde cero, sin ver partidas previas y únicamente jugando contra sí mismo.

Y es que cuando el problema a resolver está acotado por los límites y las reglas de un juego, la IA brilla, encontrando estrategias mucho más óptimas que las que encuentra un humano.

No obstante, Deepmind fue muy criticada por la poca aplicabilidad de estos modelos en el mundo real y por el dudoso retorno de la inversión que había hecho Google.

Esto cambió con la publicación de AlphaFold, un modelo capaz de predecir la estructura tridimensional de las proteínas y que ha supuesto una revolución en el campo de la Biología. Y la tendencia continúa con la publicación de este trabajo que optimiza el producto de matrices en un computador, una operación fundamental para muchos campos científicos, entre ellos el deep learning. El producto de matrices es una operación que se compone de varias multiplicaciones y sumas simples de dos números. En un ordenador, la multiplicación tiene un coste computacional mucho mayor al de la suma. Así que Deepmind ha planteado el producto de matrices como un juego de un sólo jugador, donde el objetivo es encontrar una fórmula que con el mínimo número de multiplicaciones nos dé el mismo resultado.

Al modelo responsable de jugar lo han llamado AlphaTensor, el cual ha logrado encontrar varias fórmulas que disminuyen entre un 10-20% el cómputo requerido. Aunque parezca una reducción pequeña, cuando esta operación se repite millones de veces el impacto es muy grande. En el campo del deep learning, por ejemplo, permitiría entrenar modelos más grandes con los mismos recursos computacionales. La lectura más importante de esta noticia es que la inteligencia artificial empieza a ser la artífice de pequeños descubrimientos científicos, simplemente adaptándolos al marco de un juego. Ya no hay dudas de que la inteligencia artificial es un tecnología transversal, que no sólo mejora la productividad de las empresas, sino que también permite acelerar el progreso en el ámbito científico.

Más info: https://www.deepmind.com/blog/discovering-novel-algorithms-with-alphatensor

OpenAI: vuelta a los orígenes

OpenAI comenzó en el año 2015 como una empresa sin ánimo de lucro, creada con el fin de investigar de forma abierta sobre inteligencia artificial, evitando que la tecnología caiga en manos de unos pocos y no se utilice para el bien de la humanidad. Un noble propósito que cambió en el año 2019, cuando la empresa viró al ánimo de lucro (aunque con ganancias limitadas), tras firmar un acuerdo con Microsoft por el que este último invertía 1 billón americano de dólares en la empresa. Gracias a esa inversión, OpenAI ha podido entrenar grandes modelos como GPT-3 y Dall-E 2, que han supuesto un salto cualitativo en las capacidades mostradas por el deep learning. La irrupción de Stability.ai este verano ha sacudido de lleno a OpenAI atacando a su modelo de negocio de pago por uso.

No sabemos si esta sacudida ha provocado la publicación en abierto de Whisper, un modelo de transcripción de voz, también llamado reconocimiento del habla, que además soporta múltiples idiomas. La gran diferencia frente a otros modelos de OpenAI es la disponibilidad del modelo entrenado para que cualquiera lo pueda utilizar de manera gratuita. Pero lo más sorprendente tras esta publicación es la elevada exactitud que obtiene con conversaciones de muy diversa índole, empleando la terminología adecuada según el contexto y mejorando los modelos de transcripción que hoy en día comercializan otras empresas. ¿Cómo han conseguido este logro?

Podríamos pensar que han empleado una arquitectura de redes neuronales nueva, o una forma de entrenar redes más eficiente. No es el caso, pues han empleado la popular arquitectura Transformer, tal cual fue publicada en el año 2017. El motivo que parece estar detrás de los buenos resultados es que el modelo ha sido entrenado con pares de audio y texto extraído de Internet, sin realizar una limpieza exhaustiva para asegurar la corrección de los datos. Es decir, en la adquisición de los datos ha primado la cantidad frente a la calidad. El modelo adicionalmente es capaz de hacer traducción simultánea desde cualquier idioma al inglés.

La Inteligencia Artificial se democratiza gracias al movimiento del open source, y OpenAI se sube al carro.

Esto es una excelente noticia para el progreso de este campo, y un estrés añadido para los que queremos estar al día de todas las novedades que acontecen.

Más info: https://openai.com/blog/whisper/

Gracias por leer Explicable. Si te ha gustado esta edición, no te olvides de dar al ♡ y de compartirla por redes sociales o por email con otras personas a las que creas que les pueda gustar. 💥Pero atención…💥 Si no recibieses Explicable, revisa bien tu correo no deseado. A veces ocurre que nuestros mensajes se van directamente a ese agujero negro denominado “spam”. Para evitar que esto ocurra, marca nuestra dirección de correo como “no es spam”. Si eres usuario de Gmail, revisa también la carpeta de “promociones”, porque puede que también nos hayamos escondido allí y mueve el mensaje al inbox principal. GRACIAS.