Próxima parada: el razonamiento

Noticias recientes de Inteligencia Artificial que importan a los negocios

Exploramos los límites de la IA actual en tareas de comprensión y razonamiento a partir de dos artículos publicados el mismo día y con conclusiones contrapuestas. Además, analizaremos el estado de la IA generativa en el campo de la música y en la producción de vídeo, dos áreas con mucho potencial de desarrollo aún por explotar.

Pensemos paso a paso

La ola de Inteligencia Artificial que estamos viviendo, protagonizada por la irrupción del aprendizaje profundo o deep learning, está empezando a producir resultados espectaculares cuando se aplica a gran escala. Los investigadores de renombre que trabajan en las grandes tecnológicas, los únicos capaces de entrenar estos grandes modelos, contribuyen al bombo publicitario atribuyéndoles cualidades humanas: comprensión, creatividad, razonamiento, consciencia, etc. En el lado opuesto, se encuentran los que restan importancia a los avances del deep learning, y que defienden que estos modelos son buenos imitadores de la inteligencia, pero que ni comprenden, ni razonan. Ellos apuestan por el enfoque simbólico de la Inteligencia Artificial, donde el comportamiento inteligente se obtiene operando con símbolos que representan ideas, personas, objetos, acciones, lugares, tal y como hace nuestra propia línea de pensamiento. El artículo de Gary Marcus donde señala que el deep learning ha tocado techo, unas semanas antes de que se publicara DALL·E 2, PaLM, Flamingo, Gato e Imagen, no le ha dejado en muy buen lugar.

¿Pueden los grandes modelos de lenguaje comprender nuestro lenguaje? Si para responder a esta pregunta situamos el umbral de comprensión en el nivel que posee una persona adulta, la respuesta es claramente no.

Pero si tenemos en cuenta que el modelo sólo ha visto texto escrito por humanos, sin ningún tipo de contexto previo, la capacidad para resolver tareas que requieren comprensión es asombrosa e inimaginable hace tan sólo 5 años. Además, cuando se incorpora apoyo visual al entrenamiento junto al texto, los modelos mejoran en comprensión y aparecen neuronas artificiales que se especializan en conceptos, con independencia de su representación (véase neuronas multimodales de CLIP).

Por ejemplo, la neurona que se activa con el concepto spiderman, lo hace con un cómic del superhéroe, con la foto del actor que protagoniza la película, con la foto de una araña, además de con el texto ‘spiderman’, incluso si este se encuentra insertado en una imagen. Esta es la demostración de que el deep learning sí puede crear sus propios símbolos y manipularlos para comprender la información que procesa, aunque sea de forma imperfecta. Porque para muchos casos de negocio, una comprensión como la humana no es necesaria.

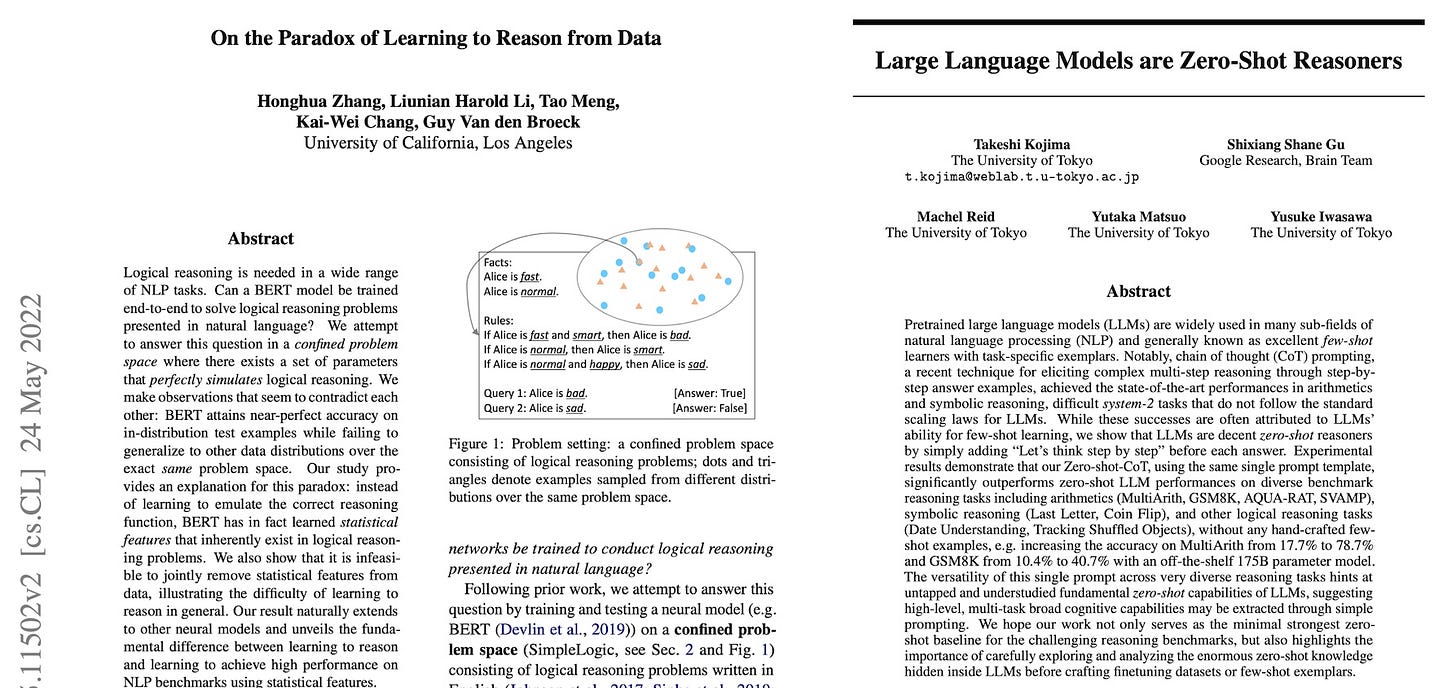

¿Pueden los grandes modelos de lenguaje aplicar razonamiento para resolver tareas?Según un artículo científico publicado el pasado 24 de mayo por investigadores de la Universidad de California, la conclusión es que no son capaces de razonar, cuando su única fuente de información es un conjunto de datos estáticos. Los experimentos de este artículo se realizan con BERT, un modelo de lenguaje mucho más pequeño que GPT-3, pero argumentan que sus resultados son extrapolables a modelos más grandes. El azar quiso que exactamente el mismo día, investigadores de la Universidad de Tokyo, en colaboración con Google, publicaran otro artículo científico donde revelan como un modelo de lenguaje como GPT-3 mejora sustancialmente su capacidad de razonamiento si añadimos esta frase junto al contexto previo: “Let’s think step by step”. Es como si el modelo nos estuviera pidiendo que, si queremos que razone, sólo tenemos que decírselo explícitamente, de otro modo no distingue si queremos que razone o que divague. Porque, claro, en sus datos de entrenamiento habrá visto ambas situaciones.

Esta disparidad de conclusiones de estos dos artículos científicos publicados simultáneamente nos enseña dos cosas: en primer lugar, que el prompt o contexto previo que introducimos a los modelos de lenguaje es fundamental para que este entienda el objetivo que buscamos. Es decir, no se puede presuponer nada, como sí hacemos habitualmente cuando nos comunicamos con otras personas, sobre todo cuando pertenecen a nuestro entorno más cercano. Y en segundo lugar, es un claro indicativo de que todavía no conocemos el funcionamiento de estos modelos, ni cuál es su verdadero potencial según aumenta su tamaño. Por eso, el debate sobre si los modelos comprenden o razonan, debería enfocarse en seguir mejorando el estado del arte y no como arma arrojadiza para minimizar el éxito del deep learning y conseguir audiencia.

Más información: https://arxiv.org/abs/2205.11502 https://arxiv.org/abs/2205.11916

Música, ¿maestro?

En los últimos meses, estamos siendo testigos del gran potencial que tiene la Inteligencia Artificial como herramienta creativa, con aplicaciones como DALL·E 2 o Imagen, capaces de generar imágenes de muchos estilos, guiadas por texto. Esta revolución tiene como precedente a los grandes modelos generativos de lenguaje, como GPT-3, capaces de generar texto a partir de un contexto o prompt descrito también en lenguaje natural. Una característica de los modelos de lenguaje es que se pueden entrenar con apenas modificaciones para cualquier tipo de lenguaje, más allá del lenguaje natural que utilizamos en nuestra comunicación. Por ejemplo, Github Copilot es una herramienta comercial de OpenAI, basada en la misma arquitectura que GPT-3, y que es capaz de generar código en varios lenguajes de programación para acelerar la productividad de los ingenieros de software.

La música es también un lenguaje que se puede representar de muchas formas. La más habitual es la partitura que ha ido evolucionando a lo largo de la historia y que todos podemos reconocer, aunque no siempre sepamos transformarla en música. Pero existen otras representaciones del lenguaje musical más idóneas para que un ordenador las procese, como es el formato MIDI. Utilizando un gran banco de obras musicales disponibles en este formato, un grupo de investigadores del Conservatorio Central de Música de China (CCOM), ha entrenado un gran modelo de lenguaje llamado SymphonyNet para que aprenda a generar los patrones de sonido a los que nosotros llamamos música. De esta manera, dándole un contexto musical de unos cuantos compases, el modelo es capaz de continuarlo y generar una obra musical completa y única.

Mientras que con DALL·E 2 podemos decir que las imágenes generadas están listas para su uso comercial, en la generación de música todavía queda camino por recorrer.

Una de las mayores dificultades es la de mantener la forma de una pieza a lo largo de toda su duración: tempo, armonía, patrones rítmicos y sonoros, repeticiones y variaciones de motivos, cambios de tonalidad.

Sin esa forma, la obra musical carece de valor. Es como si le pidiésemos a GPT-3 que escribiera un ensayo completo a partir de su título: las frases tendrán sentido de forma independiente, pero, en conjunto, faltará una línea argumental que le dé sentido al texto. Aún así, la música producida por este modelo puede servir como fuente de inspiración para compositores, que pueden extraer motivos o ideas para incorporar en sus creaciones. Las noticias de este primer semestre del año, nos llevan a pensar que en el futuro, la IA tendrá un papel muy importante en todos los procesos de creación artística.

Más información: https://symphonynet.github.io

El futuro de la IA

La gran asignatura pendiente de la IA es la capacidad de aprender del tipo de datos que más abunda en la actualidad: el vídeo. Es una fuente de información que contiene imágenes en movimiento y audio, casi todo lo necesario para que la IA entienda cómo funciona nuestro mundo.

El principal escollo para aprovechar esta ingente cantidad de datos es la mayor capacidad de cómputo requerida para procesar tanta información y aprender características relevantes que sirvan, por ejemplo, para reconocer lo que está sucediendo en una escena.

Además, tampoco existen conjuntos de datos de suficiente tamaño, con pares de vídeo y descripción de la escena que cubran la gran combinatoria de casos posibles, como sí ocurre con imágenes estáticas. Por eso, las aplicaciones de IA sobre vídeo son escasas y, la mayoría de las veces, se basan en un modelo de imagen que se aplica fotograma a fotograma.

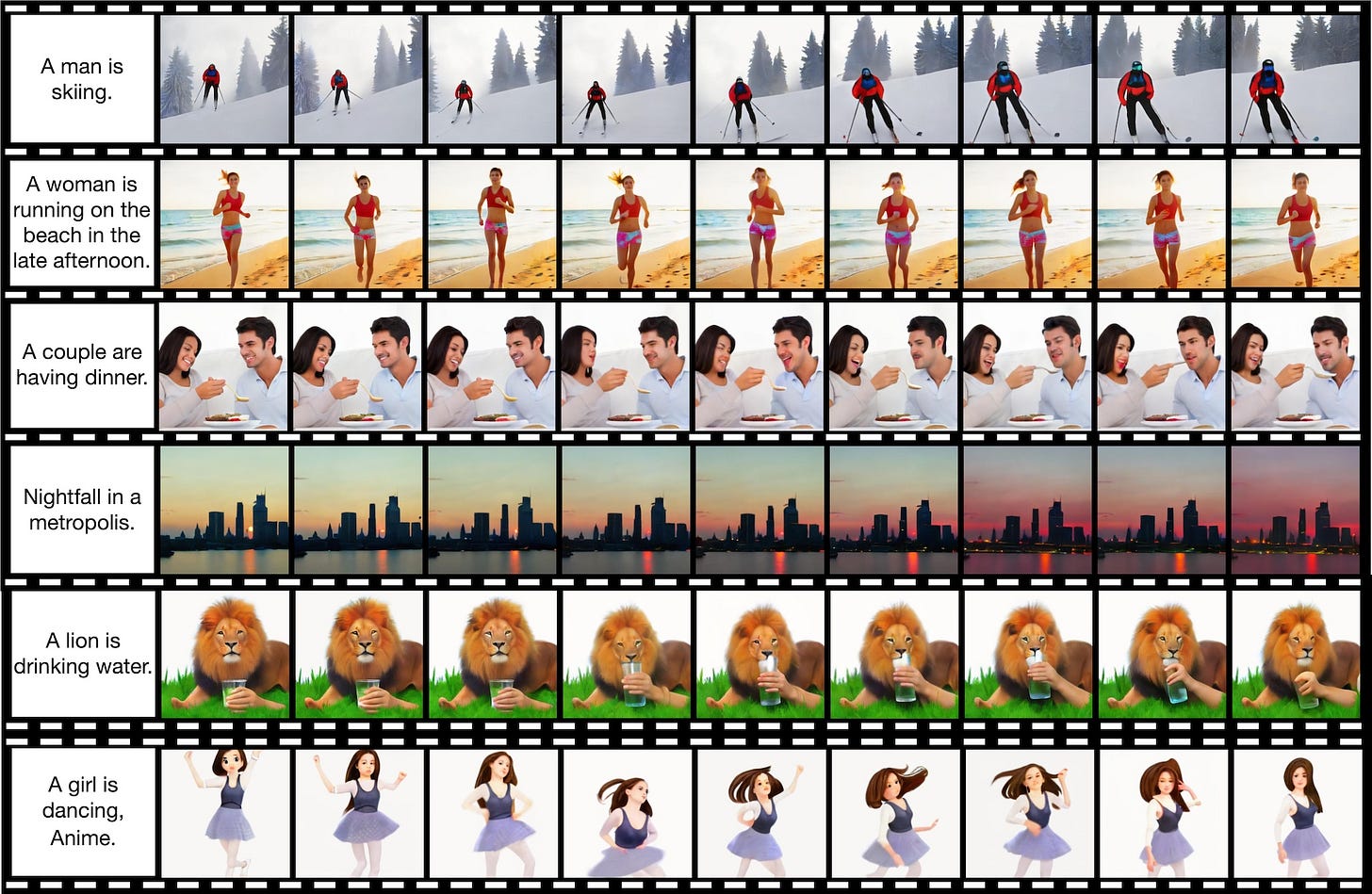

Investigadores chinos de la Universidad Tsinghua en Pekin acaban de publicar un modelo capaz de generar fragmentos de vídeo cortos en base a una descripción, llamado CogVideo, es decir, un DALL·E para vídeo. Para suplir la escasez de conjuntos de datos etiquetados que hemos mencionado, han partido de un modelo previamente entrenado por ellos mismos, llamado CogView2, y que es equivalente en prestaciones a DALL·E 2. Esto demuestra, una vez más, que China está a la altura de EE.UU. en la carrera por dominar esta tecnología.

Los resultados de CogVideo, fragmentos vídeo de tan sólo 4 segundos y 32 fotogramas en total, no son tan espectaculares como los de los modelos generativos de imágenes. Pero, no por ello dejan de ser prometedores, del mismo modo que, en el año 2014, lo fueron los primeros resultados de imágenes generadas por una arquitectura GAN. Como dice Yann Lecun, un niño de 5 años ha visto unos 800 millones de fotogramas de vídeo, audio y tacto para aprender cómo funciona el mundo. El futuro de la IA ha de pasar por el vídeo y este tipo de trabajos representan los primeros pasos.

Más info: https://arxiv.org/abs/2205.15868

Gracias por leer Explicable. Si te ha gustado esta edición, no te olvides de dar al ♡ y de compartirla por redes sociales o por email con otras personas a las que les pueda gustar.