La Metamorfosis de Facebook

Especial sobre Meta y su apuesta por la IA

Meta, la empresa anteriormente conocida como Facebook, ha orientado su futuro hacia la idea del metaverso, cambiando hasta su propio nombre como muestra de su extraordinaria fe. Pero, para que el metaverso sea económicamente viable, es necesario que la tecnología evolucione en dos áreas fundamentales: mejora sustancial del hardware especializado en VR/AR (Virtual Reality / Augmented Reality) y disminución considerable del coste de la computación.

El hardware especializado es crucial para que la experiencia sea inmersiva y los usuarios quieran pasar más tiempo en su plataforma. Viendo lo fuerte que está apostando Meta por el metaverso, podemos inferir que ya cuenta con avances aún por desvelar que suponen un salto cualitativo con respecto a los limitados dispositivos de VR/AR que se comercializan a día de hoy. Y una gran capacidad de cómputo con un bajo coste es también indispensable para recrear los mundos virtuales a escala masiva, y permitir la interacción de millones de usuarios. Además, también resulta necesaria para ejecutar los grandes modelos de IA que habilitan servicios dentro del metaverso, como asistentes virtuales para buscar información y recomendar contenidos, reconocimiento del habla, traducción simultánea, detección de postura y expresión facial, entre otros. Si nos fijamos en la historia de la informática, el incremento de la capacidad de cómputo ha sido una constante. Empresas como Nvidia son una garantía de que así seguirá ocurriendo. Por lo tanto, ninguno de estos dos avances, si bien necesarios para que el metaverso se haga realidad, deberían ser un obstáculo para Meta.

Sin embargo, el camino durante esta transformación no parece que vaya a ser fácil. Meta acaba de anunciar internamente que vienen tiempos difíciles y ha paralizado nuevas contrataciones. Pero cuenta con dos bazas que son casi un seguro de vida. Por un lado, la determinación de Mark Zuckerberg, que ha sabido sortear las dificultades a las que se ha enfrentado Facebook prácticamente desde su nacimiento. Y por otro, la visión de Yann Lecun, considerado uno de los padres del deep learning, y su especial habilidad para explotar, antes que nadie, los beneficios que ofrece la Inteligencia Artificial en los negocios.

En esta edición de Explicable nos vamos a centrar en algunos proyectos de innovación que está desarrollando Meta y que confirman que están a la vanguardia de la investigación aplicada en IA. Del mismo modo, resulta interesante destacar la filosofía que hasta ahora ha adoptado Meta de compartir abiertamente su conocimiento, a diferencia de otras grandes tecnológicas, con el fin de que toda la comunidad científica pueda construir sobre sus avances.

Ningún idioma atrás

La traducción automática es una de las muchas aplicaciones que el deep learning ha revolucionado por completo, si bien no podemos decir que todavía esté al nivel de un traductor profesional. Hasta ahora, la aproximación que se sigue es la de entrenar una red neuronal a partir de una gran cantidad de texto escrito en los idiomas de origen y destino, obteniendo un modelo especializado en traducir en una única dirección. Esto es un impedimento para los idiomas menos representados y, por tanto, con pocos datos disponibles. Con el fin de evitarlo, Meta ha creado NLLB-200, un único modelo capaz de traducir entre más de 200 idiomas, el cual equivaldría, según la aproximación anterior, a un total de 40.602 modelos especializados en cada una de las direcciones de traducción posibles. Lo más sorprendente es que el modelo traduce entre idiomas que no tienen pares de texto traducidos dentro del gran conjunto de datos de entrenamiento. Por ejemplo, el modelo sería capaz de traducir de coreano a euskera, aunque no haya visto ningún texto traducido entre ambos idiomas. De hecho, el modelo se entrena con apenas 2.440 direcciones de traducción de las 40.602 posibles. ¿Dónde está la magia?

Como prácticamente todos los idiomas tienen texto traducido al inglés, el modelo debe estar utilizando las traducciones al inglés para aprender a traducir los idiomas de los que no tiene datos de entrenamiento. Es decir, con los pares de texto de euskera e inglés, y los de coreano e inglés, está aprendiendo a traducir del coreano al euskera. Y lo mejor de todo, es que su desempeño es competitivo con respecto al de los modelos especializados en la traducción entre sólo dos idiomas. Aunque no se puede verificar, parece que el modelo ha aprendido a representar las ideas que expresamos mediante el lenguaje, con independencia del idioma que se utilice.

El modelo ya entrenado, así como el código fuente del entrenamiento y adquisición de datos, están disponibles en abierto para fines no comerciales. Uno de los primeros usos de NLLB-200 ha permitido acercar herramientas como Wikipedia a zonas del mundo con idiomas como el lingala, poco digitalizado a pesar de que lo hablan 45 millones de personas en el centro de África. Aunque quede mucho camino por delante, NLLB-200 supone el primer paso para conseguir que el idioma no sea una barrera para la comunicación entre personas, algo que desde luego será de gran utilidad en el futuro metaverso.

Más info: https://ai.facebook.com/blog/nllb-200-high-quality-machine-translation/

Creatividad a raudales

Uno de los acontecimientos del año ha sido la publicación de Dall·E 2 y todo el revuelo causado alrededor de un modelo capaz de crear imágenes originales y de alta calidad, a partir de una simples instrucciones en inglés. Gracias a Dall·E 2 pocos cuestionan ya que la Inteligencia Artificial puede ser creativa, siendo capaz de combinar conceptos que ha visto por separado en una misma imagen. Meta ha ido un paso más allá, permitiendo que además del texto en inglés, el usuario introduzca opcionalmente un boceto con la composición de la imagen esperada como un elemento más que guía el proceso generativo.

Por el momento, esta herramienta está en fase de pruebas con un número limitado de artistas especializados en arte generado por computador. Meta ha anunciado su intención de ponerla a disposición de cualquier persona que quiera aumentar su capacidad de expresión creativa, independientemente de sus habilidades artísticas. Esta democratización de la creatividad podría ser un elemento de atracción en el futuro metaverso, no sólo con la generación de imágenes en 2D, sino también con el diseño de objetos o espacios en 3D que otros usuarios puedan visitar.

Más info: https://ai.facebook.com/blog/greater-creative-control-for-ai-image-generation/

Meta Surround

Dado que el campo visual humano es limitado, el oído constituye uno de los sentidos más importantes para percibir nuestro entorno y garantizar nuestra supervivencia. Así que, en el futuro metaverso, el sonido tiene que estar muy bien cuidado para que la experiencia sea verdaderamente inmersiva. Con este objetivo, Meta ha publicado en código abierto 3 modelos de Inteligencia Artificial basados en audio.

El primer modelo se encarga de transformar el sonido para adaptarse a los escenarios virtuales donde se está escuchando. El sonido depende de la geometría de la sala, los materiales que contiene y la localización de la fuente de sonido. Todo esto se podría calcular mediante leyes físicas, pero sería muy costoso en tiempo y recursos computacionales. Existe un atajo menos costoso: se trata de hacer que un modelo de Inteligencia Artificial aprenda a relacionar la imagen de un escenario con las características intrínsecas de los sonidos que allí se reproducen.

El segundo modelo hace lo contrario del primero, es decir, elimina de un audio las características relacionadas con el espacio donde fue originalmente grabado y que no forma parte de su esencia, principalmente la reverberación de la sala. Esto sirve para limpiar el audio y poder aplicar mejor los efectos de la sala donde se escuche con posterioridad, o facilitar el reconocimiento del habla si se trata del audio de una voz. Lo novedoso de este modelo es que se apoya en la información visual del vídeo que contiene el audio para determinar las características de la sala y eliminar la reverberación de manera más precisa.

De igual manera, el tercer modelo también se apoya en información visual de un vídeo. Este modelo tiene como objetivo extraer la voz de la persona que está hablando a la cámara cuando se encuentra en un ambiente ruidoso donde se están produciendo muchas conversaciones de forma simultánea. Cuando nos encontramos, por ejemplo, en un bar muy concurrido, entendemos a un interlocutor gracias a que estamos mirándolo directamente y leemos sus labios. Meta también quiere emular la parte social de los bares en su metaverso. Por eso, es tan importante entender las conversaciones de los usuarios a los que dirigimos la mirada.

Asistente personal incluido

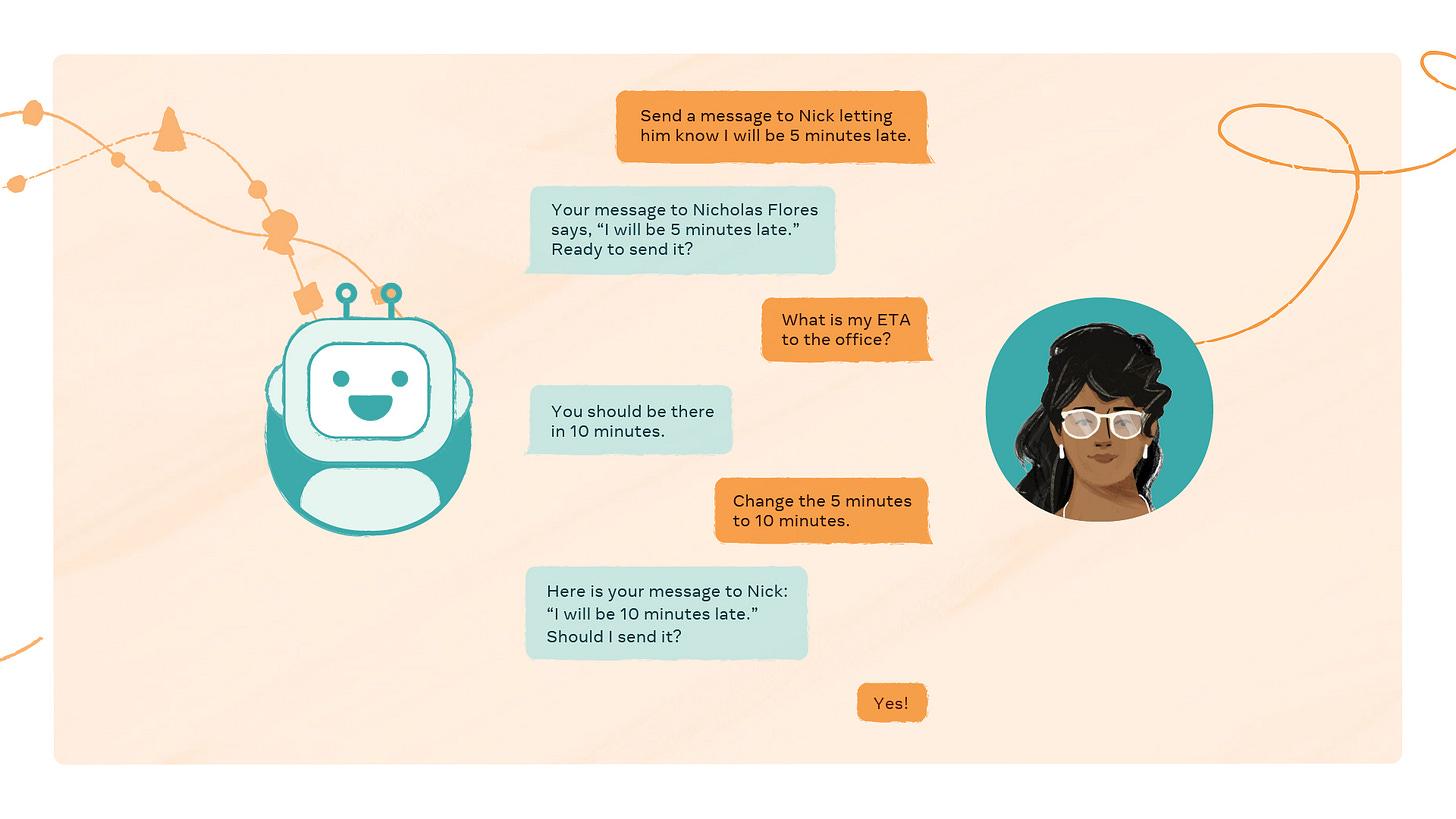

¿Quién no ha querido alguna vez tener un secretario particular que gestione nuestra vida? Es algo que en el mundo real sólo disfrutan los puestos ejecutivos de grandes empresas y los altos cargos de las instituciones públicas. Gracias a la Inteligencia Artificial y a los avances en procesamiento de lenguaje natural, estamos cada vez más cerca de que cada uno dispongamos de uno propio. Y lo mejor de todo, probablemente gratis. Eso sí, con el coste de tener que ceder nuestros datos a las empresas involucradas, de manera similar a lo que hacemos hoy con las redes sociales. Un asistente virtual nos permite organizar nuestra agenda, realizar reservas, enviar notificaciones a nuestros contactos, publicar información, recibir recomendaciones hiperpersonalizadas y un sinfín de tareas todavía por descubrir. Meta ha entendido perfectamente esta necesidad; por eso ha creado el proyecto CAIRaoke.

Los asistentes virtuales que utilizamos hoy en día, como Siri o Alexa, sólo funcionan bien para una serie tareas predeterminadas, como averiguar el tiempo de mañana, reproducir música o buscar una receta. Cuando nos salimos de lo esperado, el sistema resulta poco útil y genera mucha frustración. Lo que persigue Meta con CAIRaoke es ir un paso más allá, haciendo que la interacción con el asistente sea más natural. El primer paso es dotarle de más contexto para entender mejor nuestras necesidades y que pueda ejecutar tareas de manera fiable. Este contexto no sólo está basado en conversaciones pasadas, sino que también incluye apoyo visual como gestos que hacemos, lugar donde nos encontramos o fotos que queramos incluir en el flujo de la conversación.

A pesar del salto en el área de procesamiento de lenguaje natural que hemos vivido en los últimos años, todavía queda camino por recorrer hasta tener un asistente de estas características en el mercado. Pero una vez se consiga, no sólo será importante para movernos por el supuesto metaverso, sino que se convertirá en el futuro interfaz con las máquinas, poniendo fin a décadas de ratón y teclado.

Más info: https://ai.facebook.com/blog/project-cairaoke/

Gracias por leer Explicable. Si te ha gustado esta edición, no te olvides de dar al ♡ y de compartirla por redes sociales o por email con otras personas a las que creas que les pueda gustar.