ChatGPT: ¿bluff o revolución?

Noticias recientes de Inteligencia Artificial que importan a los negocios

El año 2012 pasó a la historia de la Inteligencia Artificial cuando una red neuronal llamada AlexNet ganó la competición de Imagenet por amplio margen frente al estado del arte de la época. Se conoce como el “momento Imagenet”, y marcó el inicio de la era tecnológica de la Inteligencia Artificial que estamos viviendo. Tras 10 años de avances en el campo del deep learning, 2022 podría pasar a la historia por ser el año en el que ocurre el “momento ChatGPT”, que establece el punto de inflexión que nos permite ver hacia dónde se dirige el campo de la Inteligencia Artificial en la próxima década. También hablaremos de la polémica publicación de Galactica, otro enorme modelo de lenguaje especializado en producir contenido de carácter científico. ¿Cuáles son los verdaderos peligros de una tecnología como esta? También repasaremos otros avances importantes en el campo de la IA aplicada como Cicero y la nueva versión de Stable Diffusion.

💥 Hasta el cartero está hablando de ChatGPT. Pero, ¿qué es realmente ChatGPT y por qué pensamos que podrá revolucionar el día a día de las empresas?

En el próximo “20 minutos de IA” analizaremos 7 usos concretos de ChatGPT que cambiarán tu día a día. Si quieres saber qué puedes hacer realmente con ChatGPT, no te pierdas este webinar 💥

ChatGPT

Tras el éxito de Dall-E 2 en abril de este mismo año, OpenAI vuelve a la carga con ChatGPT, un sorprendente chatbot de dominio abierto. ChatGPT es nuevamente un modelo de lenguaje basado en una evolución de GPT-3 y especializado en diálogos. Para evitar que ChatGPT genere lo que se conoce como alucinaciones, respuestas sin sentido fuera del contexto de la conversación, OpenAI utiliza una técnica de refinamiento de respuestas basada en el feedback proporcionado por humanos. Y el resultado es un diálogo coherente, interesante, didáctico y con infinidad de posibles aplicaciones en los negocios.

Con ChatGPT podemos responder a preguntas abiertas, recopilar información sobre un tema, extraer ideas para componer una historia y hasta escribir poemas.

Como todos los modelos de lenguaje, funciona mejor en inglés que en español, aunque con ChatGPT esa brecha es cada vez más pequeña. Por el momento, su conocimiento está congelado desde junio de 2021, fecha en la que se creó su conjunto de datos de entrenamiento y todavía no tiene acceso a Internet para obtener información actualizada.

Una de las áreas que más van a verse afectadas por esta tecnología es, sin duda, la educación. ChatGPT es capaz de realizar de manera muy solvente trabajos basados en la escritura, como redacciones, resúmenes, ensayos y poesía. Y aunque todavía con fallos, también es capaz de resolver problemas de nivel de secundaria y resolver preguntas de tipo test. Del mismo modo que ya no pedimos a los alumnos que hagan raíces cuadradas a mano y el cálculo mental tiene menos peso en el currículum académico debido a la prevalencia de las calculadoras, ¿qué pasará si tenemos un sistema capaz de escribir cualquier texto mejor que la media de la población? Por otro lado, ChatGPT también puede servir para producir material educativo, que aunque pueda contener errores, en manos de un experto, permite crear contenidos de una manera más prolífica.

De momento, está en fase de pruebas y aún no está claro el modelo de negocio de OpenAI para un sistema de estas características. Pero, interaccionando con él parece obvio que en el futuro esta será la forma de interactuar con las máquinas, mediante lenguaje natural e indicando exactamente lo que queremos que hagan. La evolución de los interfaces de usuario empezó con el teclado, escribiendo comandos predefinidos, añadió el ratón y los gráficos en pantalla para interactuar con elementos también predefinidos; y cambiará para siempre cuando sea la máquina la que, por fin, se adapte a nuestra exclusiva forma de comunicación.

El cambio de paradigma es enorme, abriendo la posibilidad de no sólo reemplazar las tediosas búsquedas en Google para encontrar información, sino permitiendo también realizar acciones en el mundo real siguiendo nuestras instrucciones.

Y esta será la próxima gran conquista de los LLMs (Large Language Models): pasar de ser potentes generadores de texto a poder planificar y actuar en un entorno abierto. Como ya hemos indicado en ediciones anteriores de Explicable, la idea de que cada uno de nosotros tenga un secretario personal se acerca cada vez más. Sólo hay que probar ChatGPT para darse cuenta de que estamos ante algo único, que ha llegado antes de lo previsto y que augura una próxima década con extraordinarios avances en el campo de la Inteligencia Artificial.

Más info: https://chat.openai.com

Galactica, ¿es peligroso?

Como ya informamos con anterioridad, estamos viviendo un resurgimiento de los grandes modelos de lenguaje, con la aparición de nuevos modelos y de multitud de aplicaciones construidas sobre estos. Meta se ha sumado a la fiesta con la publicación de Galactica, un LLM entrenado con el texto más riguroso que existe: los artículos científicos. Galactica, al igual que GPT-3, es capaz de continuar texto a partir de un contexto inicial, pero al estar especializado, puede acometer tareas específicas del ámbito científico. Por ejemplo, puede encontrar el artículo científico al que hace referencia un texto, fórmula o algoritmo, y puede convertir una fórmula en texto explicativo. Meta lo define como un asistente para que los científicos sean más productivos escribiendo sus publicaciones académicas, del mismo modo que GitHub Copilot asiste a los programadores. Esto tiene mucho sentido teniendo en cuenta la cantidad de tareas rutinarias que ocurren durante la elaboración de un paper, como la búsqueda de trabajos previos, la redacción de la introducción al campo de la investigación, la generación del abstract, y la explicación de tablas y fórmulas, entre otras.

En definitiva, estos modelos de Inteligencia Artificial generativos nos permiten empezar con algo que, con pequeñas modificaciones, puede dar lugar a contenido de calidad en un menor tiempo.

Y aquí es donde yace el aumento de productividad, simplemente eliminando la barrera mental que supone empezar a escribir partiendo del folio en blanco.

Sin embargo, si obviamos la utilidad de Galactica en la práctica científica, este trabajo de Meta arroja también resultados muy interesantes. Por ejemplo, que a pesar de haber sido entrenado con mucho menos datos que otros modelos de mayor tamaño como OPT-175B y Bloom, sus prestaciones son mucho mejores, quizá achacado a la rigurosidad de los datos de entrenamiento.

La polémica que ha suscitado se encuentra en las demás capacidades que Meta se ha encargado de eliminar de su web por miedo a la mala prensa, como la de escribir artículos de wikipedia sobre un tema, o responder a preguntas de índole científica. Según miembros de la comunidad científica, esto podría utilizarse para diseminar la desinformación, dado que el contenido producido suena asertivo aunque esté compuesto de falsedades. Exactamente el mismo problema se planteó cuando se publicó GPT-2, y el modelo quedó congelado por miedo a provocar el caos mundial. No sólo no fue así una vez decidieron publicarlo, sino que posteriormente apareció GPT-3, con una capacidad muy superior y que se comercializa desde hace 2 años a un precio muy asequible.

Aunque estos modelos puedan generar noticias falsas, también lo puede hacer un humano de una manera más sutil y difícil de detectar. Por eso, el elemento clave en la desinformación no es la capacidad de crear el contenido falso, sino el contar con un canal de distribución masivo.

Es decir, es más fácil manipular y desinformar desde un medio de comunicación, desde la tribuna de un congreso, o siendo influencer en redes sociales, que teniendo en tus manos el modelo de lenguaje más potente que puedas imaginar.

Toda esta controversia ha provocado que Meta dé marcha atrás y cierre el acceso a Galactica, pidiendo disculpas por no haber medido bien el potencial impacto de esta tecnología. La mala fama que tiene Meta por sus errores del pasado tampoco ha ayudado a que este trabajo se vea con buenos ojos. La pregunta que habría que hacerse es: ¿por qué no ha pasado lo mismo con ChatGPT publicado dos semanas después? La realidad es que Galactica no es más peligroso que ChatGPT en su capacidad para generar contenido creíble y potencialmente falso. La gran diferencia estriba en que Galactica entra de lleno en una parcela reservada para los científicos, una comunidad que en los últimos años se ha volcado en exceso en el estudio de los problemas éticos derivados del uso de la Inteligencia Artificial. Recordemos que la desinformación ha formado parte de la historia de la humanidad y es la sociedad, no la ciencia, la responsable de establecer los mecanismos de protección adecuados según las formas que esta adopte.

Más info: https://galactica.org

CICERO realmente convence

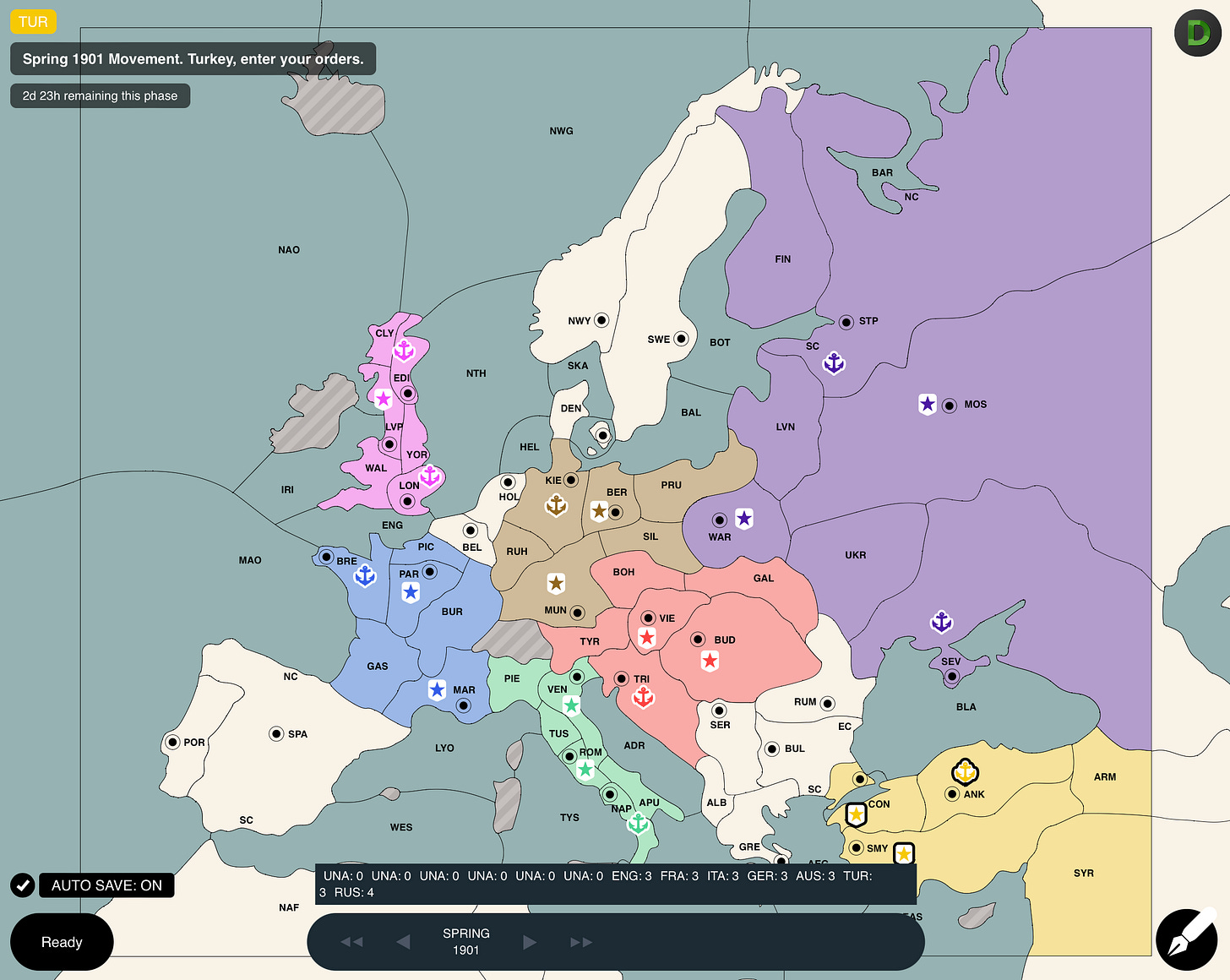

Seguimos con Meta, que nos ha presentado a Cicero, un sistema de Inteligencia Artificial basado en la técnica de aprendizaje por refuerzo, que es capaz de jugar de manera muy competente al juego de estrategia Diplomacy. Hasta aquí podría ser cualquiera de los logros que hemos visto en el pasado con el Ajedrez, el Go, el Starcraft, y otros muchos juegos conquistados por esta misma técnica, donde la capacidad de percepción, predicción, planificación y razonamiento se unen para lograr un agente imbatible frente al humano. Pero lo que convierte este avance en algo único es que para ganar al Diplomacy es necesario negociar con los adversarios para forjar alianzas, además de la elección de una buena estrategia de movimientos. Y esa negociación se realiza utilizando el lenguaje natural, donde entra en juego la capacidad de comprender, generar confianza, persuadir y empatizar con el contrincante.

Para ello han utilizado, cómo no, un gran modelo de lenguaje que han ajustado con las conversaciones extraídas de 40.000 partidas jugadas por humanos y etiquetadas para hacer referencia a la acción en el tablero que hay detrás de cada frase. Una vez Cicero está en pleno juego, utiliza el histórico de conversaciones mantenidas y de movimientos para predecir la intención de todos los jugadores, el mejor próximo movimiento y qué mensajes enviar a determinados jugadores. Cicero logra estar en el top 10 de jugadores, algo que resulta sorprendente teniendo en cuenta que lo han entrenado para ser honesto en sus mensajes, a pesar que la traición y la mentira pueden ser de gran ayuda en este tipo de juegos. Por otro lado, Cicero es frío y calculador, y no se deja llevar por las emociones como la venganza, algo que por sentado afectará a sus oponentes humanos.

En definitiva, este trabajo supone un banco de pruebas ideal para entender mejor las relaciones entre humanos y máquinas cuando se encuentran en un mismo escenario, con distintos objetivos, y donde se tienen que entender y poner de acuerdo para alinear al máximo sus intereses.

Más info: https://ai.facebook.com/research/cicero/

Stable Diffusion 2.X

Y acabamos haciéndonos eco de la publicación de una nueva versión de Stable Diffusion, el modelo de generación de imágenes que causó furor este verano se ha actualizado completamente con tan sólo 3 meses de vida. ¿Qué tiene ese modelo de nuevo? Por un lado, genera imágenes de más resolución que su predecesor (768x768), aunque todavía no llega a la resolución de su principal competidor Dall-E 2 (1024x1024). Eso sí, viene con un modelo independiente capaz de aumentar la resolución de las imágenes generadas hasta 2048x2048. Además, incluyen un modelo específico para edición de imágenes y otro para obtener el mapa de profundidades de una imagen dada. Aunque no lo hemos podido probar aún, predecir esta información parece un paso muy prometedor para mejorar la generación actual de imagen a imagen, manteniendo la consistencia espacial de la imagen original, como podemos ver en el siguiente ejemplo:

Pero lo que más ha causado sorpresa es que los textos utilizados para guiar la generación funcionan de manera totalmente distinta. Uno de los motivos es que han cambiado el codificador de texto a OpenCLIP, creado a partir del mismo conjunto de imágenes, sustituyendo a CLIP, creado por OpenAI con un conjunto de imágenes desconocido. Esto hace que Stable Diffusion 2.x genere imágenes más fieles al texto inicial, aunque por otro lado elimina todos los trucos que la comunidad ha ido acumulando para explotar al máximo la calidad de las imágenes generadas, algo que no ha gustado a los usuarios.

Otro de los cambios no muy bien recibidos es que han puesto el foco en limpiar mejor los datos de entrenamiento para evitar problemas legales. No hay que olvidar que Stability.ai ya es un unicornio, es decir, una empresa privada valorada en más de 1 billón de dólares. Esta limpieza mediante un filtro automatizado, ha provocado que la versión 2.0 genere excelentes imágenes de paisajes, arquitectura, interiores y animales, pero deje mucho que desear en cuanto a la generación de personas. Dos semanas de quejas han bastado para solucionar el problema, con la publicación de la versión 2.1 de Stable Diffusion que no es tan agresiva filtrando las imágenes potencialmente sensibles durante el entrenamiento. Con este movimiento, Stability.ai demuestra que sigue muy comprometida con la filosofía de código abierto, escuchando a su comunidad de usuarios y reaccionando muy rápido a sus peticiones.

Más info: https://stability.ai/blog/stable-diffusion-v2-release

Gracias por leer Explicable. Si te ha gustado esta edición, no te olvides de dar al ♡ y de compartirla por redes sociales o por email con otras personas a las que creas que les pueda gustar. 💥Pero atención…💥 Si no recibieses Explicable directamente en tu correo, revisa bien tu correo no deseado. A veces ocurre que nuestros mensajes se van directamente a ese agujero negro denominado “spam”. Para evitar que esto ocurra, marca nuestra dirección de correo como “no es spam”. Si eres usuario de Gmail, revisa también la carpeta de “promociones”, porque puede que también nos hayamos escondido allí y mueve el mensaje al inbox principal. GRACIAS.